Neuer Cluster-Computer am Albert-Einstein-Institut macht Schwarze Löcher berechenbar

In Golm bei Potsdam etabliert sich ein Kompetenzzentrum für wissenschaftliches Rechnen

Knapp 100 Jahre nach der Entwicklung der Relativitätstheorie durch Albert Einstein ist unser Wissen über die Gravitationsphysik rasant angewachsen. Zweifelte Einstein z.B. die Existenz Schwarzer Löcher noch stark an, sind wir heute sicher, dass es sie gibt. Diese Sicherheit verdanken wir u.a. den Fortschritten der Computerforschung. Immer schneller arbeitende Computer ermöglichen heute, die komplexen Denkmodelle und Theorien der Gravitationsphysiker zu testen, realistische astrophysikalische Systeme zu simulieren und sie dreidimensional zu visualisieren.

Aber schnell ist manchmal nicht schnell genug. Am Golmer Max-Planck-Institut für Gravitationsphysik (Albert-Einstein-Institut, AEI), dem internationalen Zentrum der Relativitätstheorie, sitzen die weltweit führenden Köpfe der Gravitationsphysik. Die Forschung hier ist in eine Dimension vorgedrungen, der der 1997 in Betrieb genommene Hochleistungsrechner SGI-CRAY Origin 2000 nicht mehr gerecht wurde. Übergangsweise wurden Rechenläufe daher an internationalen Hochleistungsrechenzentren, wie etwa dem NCSA in den USA durchgeführt. Da dies jedoch ist mit einem hohen Abwicklungsaufwand verbunden ist, hat das AEI nun ein Hochleistungs-Linux Compute Cluster mit der ca. 20-fachen Leistung der CRAY beschafft.

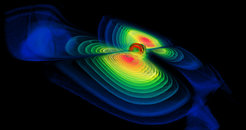

„Wir sind glücklich, unsere Theorien und Modelle z.B. zu astrophysikalischen Ereignissen, wie dem Verschmelzen zweier Schwarzer Löcher, jetzt unmittelbar am Institut testen und somit schneller und effektiver arbeiten zu können“, so Prof. Bernard Schutz, Geschäftsführender Direktor des AEI. „Wir leisten damit auch einen entscheidenden Beitrag zum Fortschritt internationaler Großprojekte wie GEO600 (erdgebundene Gravitationswellenmessung) oder LISA (Gravitationswellenmessung im Weltraum).“

PEYOTE

Der neue Cluster am AEI bekam von der Gruppe Numerische Relativitätstheorie um Prof. Edward Seidel den Namen PEYOTE – wie "Parallel Execute Your Own Theoretical Equation". Peyote ist auch der Name einer hauptsächlich in Mexiko beheimateten Kakteenart (in Deutschland bekannt unter dem Namen Schnapskopfkaktus). Der Name lag daher auch insofern nahe, als das Programm, das überwiegend auf dem Cluster verwendet wird, seinerseits weltweit unter dem Namen CACTUS bekannt ist (www.cactuscode.org).

Hauptbenutzergruppe sind die Wissenschaftler der Abteilung Astrophysikalische Relativitätstheorie und insbesondere von der Gruppe Numerische Relativitätstheorie unter Leitung von Prof. Seidel. Aber auch Wissenschaftler anderer Gruppen und Kooperationspartner sind Benutzer dieses Hochleistungsclusters.

Das Cluster eignet sich insbesondere für Probleme, die sich gut parallelisieren lassen. Das sind Matrizenoperationen, wie sie maßgeblich auch für Simulationsberechnungen verwendet werden. Dafür müssen die einzelnen Knoten des Clusters besonders schnell und effektiv miteinander kommunizieren können. Die Berechnung der Einstein-Gleichungen für astrophysikalisch interessante Fälle wie etwa den Zusammenstoß Schwarzer Löcher oder Neutronensterne ist das Hauptforschungsgebiet der Gruppe Numerische Relativitätstheorie. Die Ergebnisse dieser Simulationsberechnungen werden entweder auf dem Headnode des Clusters oder auf Workstations, die besonders für Graphikausgabe geeignet sind, visualisiert.

Das Max-Planck-Institut für Gravitationsphysik

Das Max-Planck-Institut für Gravitationsphysik (Albert-Einstein-Institut) in Golm bei Potsdam hat sich seit seiner Gründung 1995 als international führendes Forschungszentrum für Gravitationsphysik etabliert. Über 90 Wissenschaftlerinnen und Wissenschaftler sowie jährlich mehr als 150 Gastforscher arbeiten hier an allen Aspekten der Gravitationsphysik.

Der Cluster / technische Daten

Es handelt sich um einen Hochleistungs Linux Compute Cluster. Es besteht aus 64 Rechenknoten, mit jeweils 2 Intel XEON P4 Prozessoren mit einer Leistung von je 2.66 GHz und 2 GB RAM und lokalem Speicherplatz von 120 GB pro Knoten.

Vier so genannte Storageknoten werden die großen Mengen von Ergebnisdaten auf einem ca. 5 TB großen Speichersystem aufnehmen. Drei Netzwerke sorgen für die Kommunikation der einzelnen Rechner untereinander. Jedes dieser Netzwerke hat seine ganz besondere Aufgabe.

Herzstück des Hochleistungsclusters ist das Netzwerk und damit der entsprechende Switch, der für die Interprozesskommunikation sorgt. Diesen Switch lieferte die Firma Force10Networks. Hier kommt es in besonderem Maße auf kleine Latenzzeiten und verzögerungsfreie Datenübertragung an, die durch die GigaBit Ethernet Technologie gewährleistet wird.

Obwohl heute vielfach Myrinet, eine Hochleistungsswitchtechnik, eine große Rolle spielt, hat man sich für GigaBit entschieden, da dieser Quasistandard auch in der Zukunft günstige Ausbaumöglichkeiten und ein optimales Preis/Leistungsverhältnis verspricht.

Da typische Rechenläufe mehrere Tage oder gar Wochen dauern, werden die Runs durch ein Batchsystem verwaltet. Die Benutzer kommunizieren über Managementknoten mit dem Cluster. Er compiliert dort seine Programme und visualisiert auf diesen Knoten die Ergebnisse. Ein ganz wesentlicher Teil für all die rechnerischen Aufgaben der Wissenschaftler des AEI übernimmt der am AEI entwickelte CACTUS Code (www.cactuscode.org), ein flexible Auswahl von Tools, die es allen Wissenschaftlern leicht ermöglicht, Problemstellungen computergerecht zu formulieren und Berechnungen ausführen zu lassen.

Schon jetzt plant man die 2. Ausbaustufe des Hochleistungsclusters, so dass Ende 2003 das Cluster aus 128 PC-Knoten mit mindestens 12 TB Speicherbereich bestehen wird. Angestrebt ist ein Ausbau auf 256 PC Knoten für das Cluster.

Details

Jeder Rechen-Knoten hat drei Netzwerkkarten für drei spezifische Netzwerke.

Das wichtigste ist das InterconnectNetzwerk, das die Rechenknoten mit 1000Mbit/s (1Gbit/s) Leitungen über einen besonders leistungsstarken Switch miteinander verbindet. Hier wird ein Switch der Fa. Force10Networks eingesetzt. (Switchbeschreibung siehe unten). Er hat eine Backplane (BUS-Leiterplatte)-Kapazität von 600 Mbit/s.

Das zweite, ebenfalls sehr wichtige Netzwerk dient der Übertragung der Ergebnisse der einzelnen Knoten auf die so genannten Storagenodes (Speicherknoten). Wegen der enormen Datenausgabe der Rechenknoten empfiehlt es sich die Last auf mehrere Knoten zu verteilen. So wird der Output von 16 Knoten auf jeweils einen Storagenode geschrieben. Dieses Netzwerk wird durch eine HP ProCurve 4108gl Switch bedient. Er hat eine Backplane von 36 Gbit/s. Das reicht aus, um eine Last von 4 Mbyte/s von jedem! Rechenknoten gleichzeitig zu bewältigen.

Das dritte Netzwerk dient dazu alle Komponenten des Clusters überhaupt bedienen zu können. Hier wird ebenfalls ein Switch der Firma HP eingesetzt. Um die Kabellängen möglichst kurz zu halten, werden in diesem Netz noch zusätzlich 2 weitere Switche eingesetzt. Hier ist der Hersteller die Firma 3Com.

Kühlung des Clusters

Wegen des geringen Platzbedarfs hat man sich für SlashTwo Gehäuse entschieden. Diese gepackte Form erfordert besondere Berücksichtigung der Luftströme in dem Gehäuse, da die Prozessoren eine enorme Wärme abgeben, die möglichst schnell abtransportiert werden muss.

Die Raumluft sollte 20°C nicht überschreiten

Es muss dafür gesorgt werden, dass ein Luftvolumen von 4 x 1400 qm vorhanden ist und umgewälzt werden kann.

Die vorhandene Klimaanlage kann diese Werte bewältigen und hat eine Leistung von ca. 50kW. Die vorhandenen Deckengeräte stehen für die besonders sonnenintensiven Sommertage als Reserve zur Verfügung und leisten zusätzlich 24 kW.

Stromversorgung

Das Cluster wird mit 6x25A Leitungen versorgt. Eine USV (Unterbrechungsfreie Stromversorgung) sorgt im Falle eines Stromausfalls für max. 20 Minuten für eine gleichmäßige Stromversorgung der Storage- und Headnodes.

Spezielle Software sorgt dafür, dass diese Rechner dann automatisch ordnungsgemäß heruntergefahren und ausgeschaltet werden.

Weitere Maßangaben

Cluster

Pro Rack (19" Schrank):

Gewicht: 400 kg mit 16 SlashTwo Gehäusen

240 kg für den Netzwerkschrank

250 kg für das Rack mit den Storage-und Headnodes, einschließlich der 6 TB Speichereinheiten

Netzwerk

Force10Networks E600

Gewicht: 110 kg

Stromverbrauch: 2800 W

Abwärme: 1400W - 3500W

Netzspezifikationen

Backplanekapazität: 600 Gbit/s

Spezielle Software

Obwohl das Cluster als eine Einheit betrachtet werden kann, müssen doch die einzelnen Komponenten softwaremäßig einzeln benutzbar sein. Hier sorgt spezielle Software, eine so genannte Managementsoftware für enorme Vereinfachung. Die Firma Megware hat dazu eine Clustermanagementsoftware namens Clustware entwickelt.

Besonderheiten des Clusters

PeakPerformance des Clusters

Theoretisch: 128 x 2 x 2,66GHz = 680GFlops/s (128 CPUs , pro CPU 2 Floating Point Units, 2.66GHz pro Unit)

Die wahren Werte werden sich in den Benchmarks herausstellen.

Ein einzelner PC, wie er im Cluster (2 CPUs) verwendet wird und als DesktopWorkstation einigen Wissenschaftlern am AEI zur Verfügung steht, leistet 10 Gflops/s.

Das Communication network basiert auf Gigabit Ethernet. Diese Netzwerkkarte wurde gewählt, weil man davon ausgeht, dass die Entwicklung von Ethernet weiter voranschreitet. Der InterprocessSwitch ist bereits für 10 Gigabit Ehternet ausgelegt.

Vergleich mit anderen Rechnern

Dem Institut steht zusätzlich eine ORIGIN 2000 mit Virtual Realiyty Graphics Engine zur Verfügung. Dieser 1997 als Hochleistungsrechner beschaffte Parallelrechner kann mit den heutigen Anforderungen nicht mehr mithalten.

Die ORIGIN ist mit 32 CPU ausgestattet und hat 8GB memory. Immerhin hat sie eine Leistung von 20 - 40 Gflops, was vor 3 Jahren eine sehr gute Leistung war. Heute kann man die Systeme nicht mehr vergleichen, denn ein einzelner PC, wie er im Cluster (2 CPUs) verwendet wird, leistet bereits 10 Gflops/s. Ein tatsächlicher Vergleich mit anderen Clustern und anderen Hochleistungssystemen wird sich daher erst im Laufe der nächsten Wochen und Monate anstellen lassen.

Trotzdem hier Angaben eines anderen Cluster (High Performance Computing Center North (HPC2N):

240 CPU's in 120 Dual nodes

2 AMD Athlon MP2000+ Processors

1 Tyan Tiger MPX Motherboard

1-4 GB Memory

1 Western Digital 20GB Hard disk

1 Fast ethernet NIC

1 Wulfkit3 SCI

Für dieses Cluster wird eine PeakPerformance von 800 Gflops/s angegeben.